揺らぎの中で見えるもの

ブラックボックスだと言われてきた深層学習の内部構造をinformation plane上の相互情報量の変化として捉えることで、学習過程に潜む構造の輪郭を浮かび上がらせる

著者: 加賀涼介

見えないもの

何が深層学習をブラックボックスだと言わしめているだろうか?

深層学習の計算も学習アルゴリズムも数式として表すことができる。数式的にもアルゴリズム的にも誤差の減少や収束については説明できる。ブラックボックスと言われる所以は何を学んだかを説明できないことであろう。

この意味を体感するために、具体的な最適化の手順に焦点を当ててみよう。 学習における重みの最適化は勾配を小さくすることで行われる。ある深層学習モデルにを計算した時の損失をL、パラメータをθとすると、勾配は

となる。

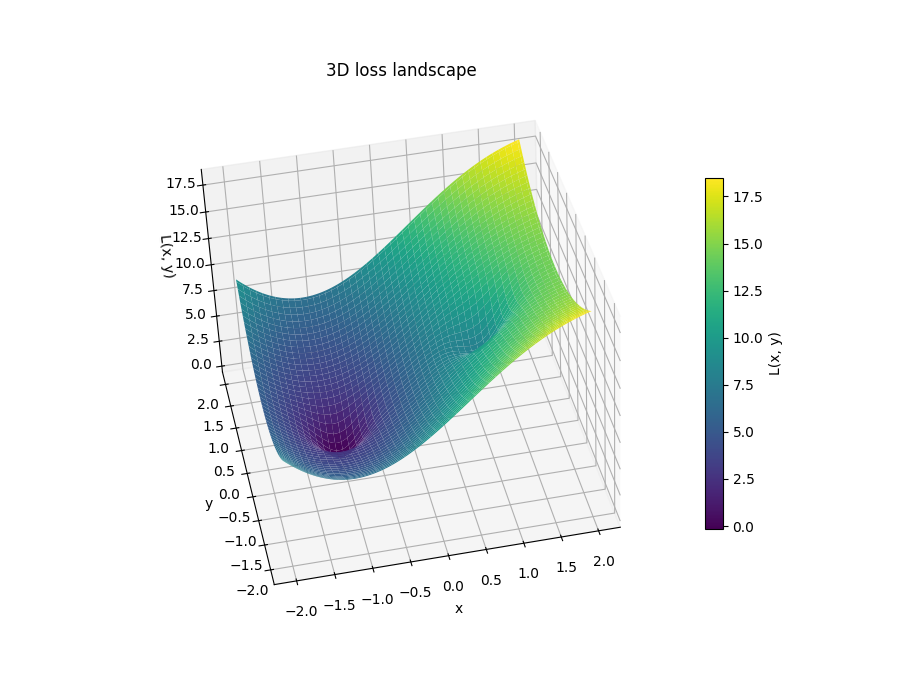

見やすいように特に意味もない2次元空間上の損失地形を示すと、

勾配を用いて最適化を行うということは、 この損失地形の「谷」を下る方向へと進むことに対応する。 これは純粋に幾何的な見方である。

例えば、この (x, y) がそれぞれ BTC/JPY、ETH/JPY のレートであり、 それらから同時刻の XRP/JPY のレートを予測するモデルを学習させたとしよう。 このモデルを学習させ、テストデータに対して高い精度を出せたとする。 この時、私たちが説明できるものとは。

説明できるのは、 「損失関数が最小化され、その結果として良い予測性能が得られた」 という事実だけである。